准备工作

开始之前,请确保您已准备好以下各项:

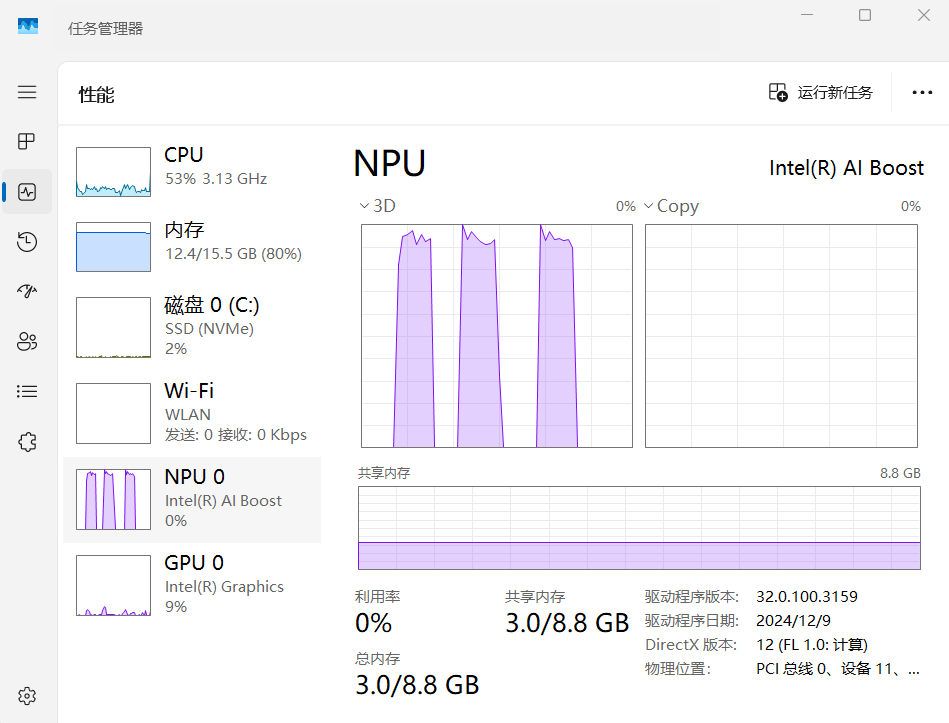

- 一台配备NPU(神经处理单元)的戴尔PC。这可以是搭载英特尔酷睿 Ultra系列或高通骁龙 X系列的笔记本电脑或台式机。

- 从以下百度网盘下载Dell Pro AI Studio相关的安装包。

第一步:搭建运行环境

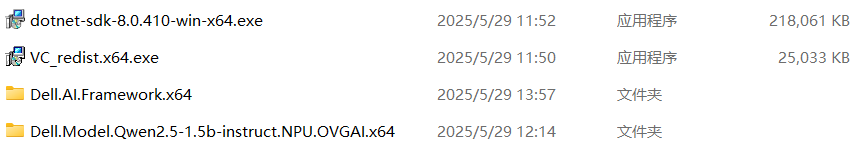

此步骤我们将安装Dell Pro AI Studio所需的核心组件。请确保您已下载以下文件:

Dell.AI.Framework.x64.zip(适用于Intel Ultra CPU) 或Dell.AI.Framework.ARM64.zip(适用于Qualcomm Snapdragon CPU)dotnet-sdk-8.0.x-win-x64.exe(或微软提供的最新兼容版本 .NET SDK)VC_redist.x64.exe(Visual C++ Redistributable)

1. 安装 Microsoft .NET SDK (含Runtime)

运行下载的 dotnet-sdk-8.0.x-win-x64.exe 文件,并按照屏幕提示完成安装。这将同时安装必要的 .NET Desktop Runtime。

2. 安装 Visual C++ Redistributable

运行下载的 VC_redist.x64.exe 文件,并按照屏幕提示完成安装。

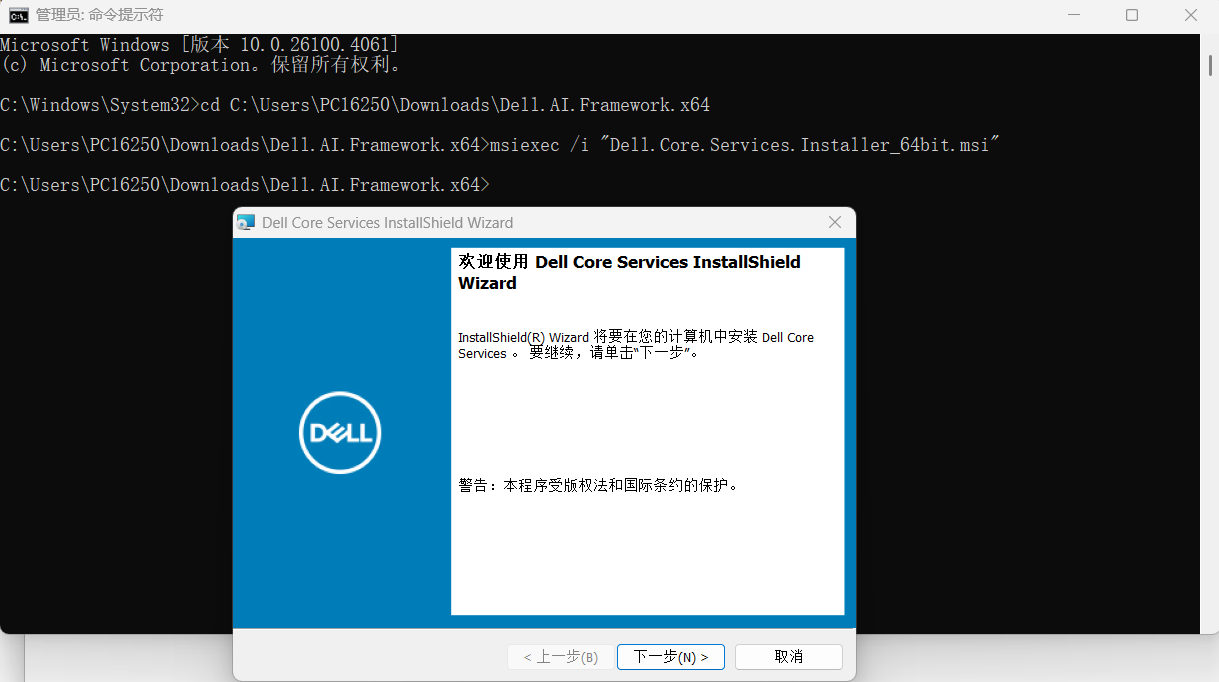

3. 安装 Dell Pro AI Studio Core

根据您的处理器类型选择正确的文件版本。

- 解压下载的

Dell.AI.Framework.*.zip文件到您选择的目录 (例如:C:\\DellProAIStudio_Setup)。 - 以 管理员权限 运行命令提示符 (CMD)。

- 在CMD中,导航到您解压文件的目录。例如:

cd C:\\DellProAIStudio_Setup\\Dell.AI.Framework.x64 - 依次执行以下命令来安装核心服务和框架:

msiexec /i "Dell.Core.Services.Installer_64bit.msi" msiexec /i "Dell.AI.Framework.x64.msi"对于ARM64架构,文件名将包含 "ARM64"。

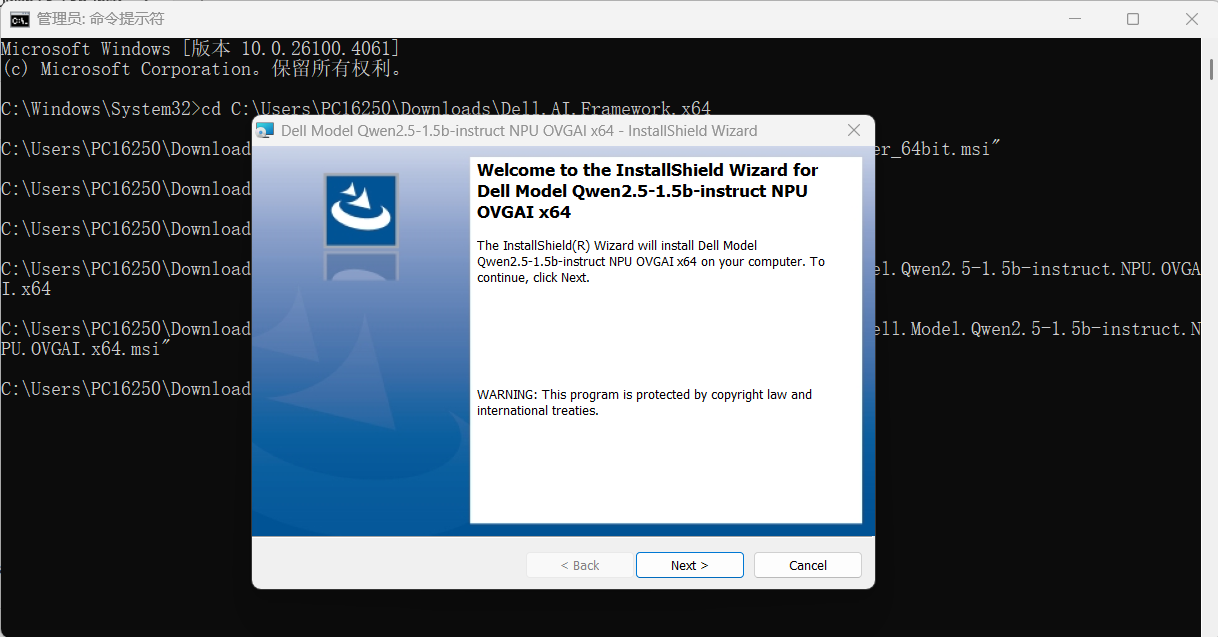

第二步:部署AI模型 (以Qwen2.5为例)

现在,我们将安装一个具体的AI模型。本教程以Qwen2.5为例。您下载的文件名可能因模型版本而异,例如 Dell.Model.Qwen2.5-1.5b-instruct.NPU.OVGAI.x64.zip。

- 解压下载的模型压缩包 (例如

Dell.Model.Qwen2.5-1.5b-instruct.NPU.OVGAI.x64.zip) 到一个新目录。 - 再次以 管理员权限 运行命令提示符 (CMD)。

- 导航到您解压模型文件的目录。

- 执行模型安装命令 (文件名请根据实际下载的调整):

msiexec /i "Dell.Model.Qwen2.5-1.5b-instruct.NPU.OVGAI.x64.msi"

服务就绪!

安装完成后,AI模型服务将在您的本地计算机上通过以下地址提供:

http://localhost:8553/v1/openai

默认模型名称 (ID) 通常为 qwen2.5 (或安装包内指定的名称),API Key 为 dpais。

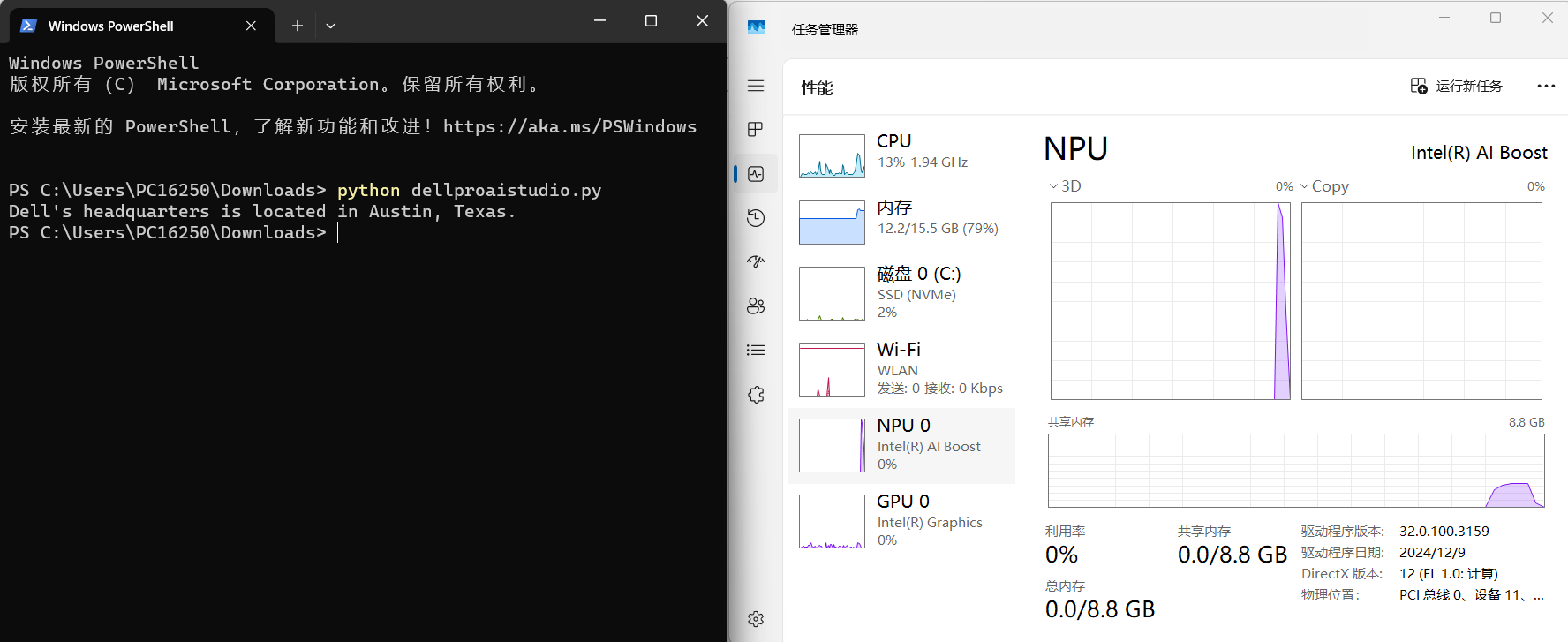

NPU加速服务:验证与使用入门

恭喜!您的戴尔AI PC现在已经通过NPU在 8553 端口上提供了一个与OpenAI API兼容的服务。这与大家熟知的Ollama在 11434 端口提供模型服务的方式非常相似。

接下来,我们将通过两个实际案例——Python脚本调用和Cherry Studio图形化界面——来演示如何利用这强大的本地AI算力。

通过Python调用NPU

通过Python与NPU服务交互非常简单。首先,请确保您已安装 openai Python库:

pip install openai以下是一个示例Python脚本。请注意脚本中的三个关键参数:

api_key: 固定为"dpais"base_url: 固定为"http://localhost:8553/v1/openai"model: 您安装的具体模型ID,例如"qwen2.5"(请根据实际情况修改)

# -*- coding: utf-8 -*-

from openai import OpenAI

# 配置客户端连接到本地Dell Pro AI Studio服务

client = OpenAI(

api_key="dpais", # 固定API Key

base_url="http://localhost:8553/v1/openai" # 本地服务地址

)

# 定义要使用的模型ID (请替换为您安装的模型)

MODEL_ID = "qwen2.5"

try:

print(f"正在使用模型: {MODEL_ID}")

# 创建聊天请求

response = client.chat.completions.create(

model=MODEL_ID,

messages=[

{"role": "system", "content": "you are a helpful assistant"},

{"role": "user", "content": "hello! where is Dell's headquarter located?"},

],

stream=False

)

# 打印助手的回复

print(response.choices[0].message.content)

except Exception as e:

print(f"\n发生错误: {e}")

print("请检查以下事项:")

print("1. Dell Pro AI Studio 服务是否已正确启动。")

print(f"2. 模型ID '{MODEL_ID}' 是否正确无误且已成功安装。")

print("3. 网络连接是否正常,端口8553是否被防火墙阻止。")

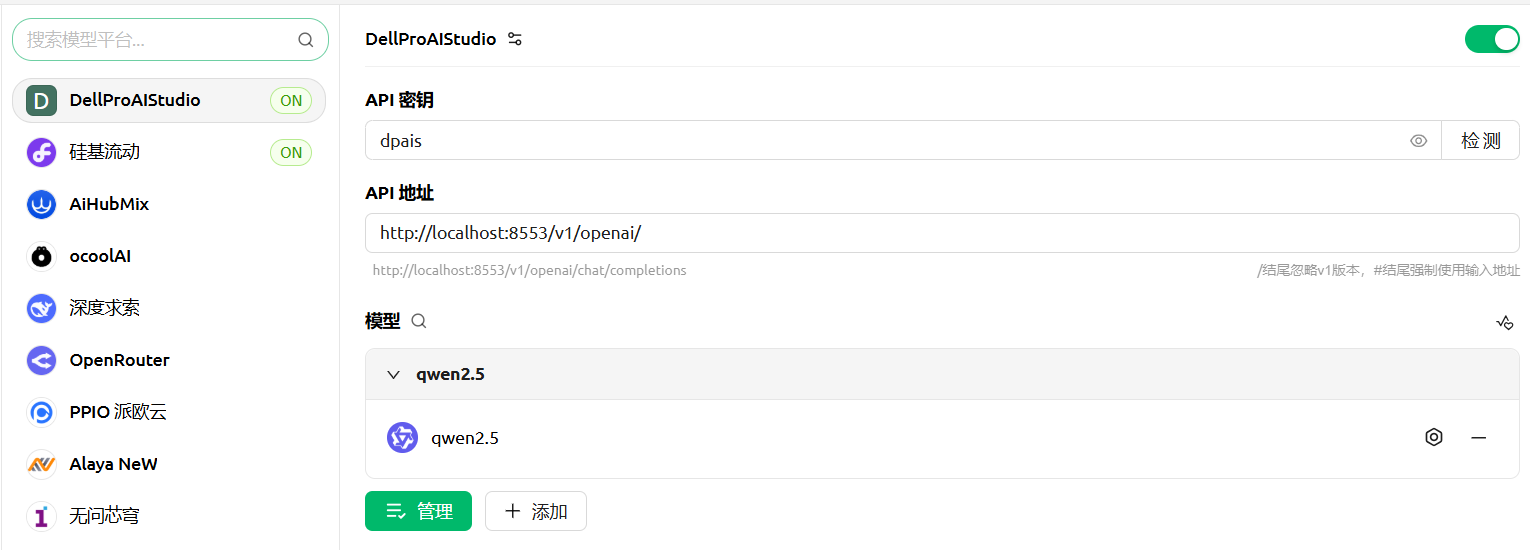

通过Cherry Studio调用NPU

如果您偏好使用图形化工具,Cherry Studio是一个不错的选择。按以下步骤配置即可调用NPU算力:

- 首先,下载并安装Cherry Studio (例如

Cherry-Studio-1.3.12-x64-setup.signed.exe)。 - 打开Cherry Studio应用程序。

- 导航至程序内的“设置”菜单,然后选择“模型服务”选项。

- 在模型供应商列表的底部,找到并点击“+添加”按钮以新增一个供应商。

- 在弹出的配置窗口中,填写以下信息:

- 供应商名称: DPAIS (或者您喜欢的任何名称,如 "Dell NPU")

- 供应商类型: 从下拉菜单中选择 "OpenAI"

- 现在,配置刚刚添加的DPAIS供应商:

- API密钥: 输入

dpais - API地址: 输入

http://localhost:8553/v1/openai/ - 点击“添加模型”按钮。在“模型ID”字段中输入您安装的模型名称 (例如

qwen2.5),然后再次点击“添加模型”按钮确认。

- API密钥: 输入

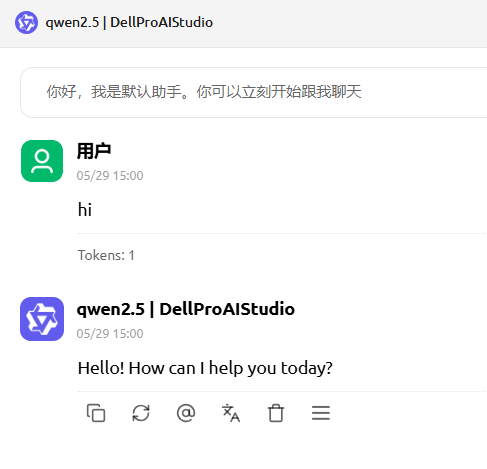

- 配置完成后,返回Cherry Studio的主聊天窗口。

- 在模型选择下拉菜单中,您应该能看到并选择类似

qwen2.5 | DellProAIStudio的选项。 - 选中后,您就可以开始与通过NPU加速的本地AI模型进行交互了!